|

20#

发布于:2016-10-01 00:46

http://money.163.com/16/0930/13/C27EB6H1002580S6.html

谷歌神经网络翻译媲美真人笔译?

日前,谷歌推出神经网络翻译,翻译质量接近人工笔译。这让人们不禁发出感叹:“是不是以后我们都不用学英语了?” 早报记者 徐明徽 实习生 李娇

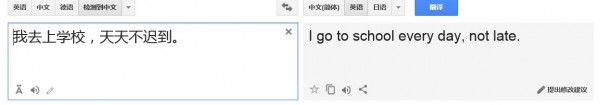

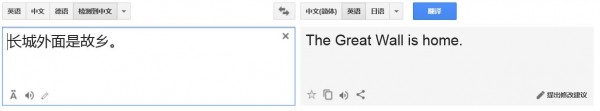

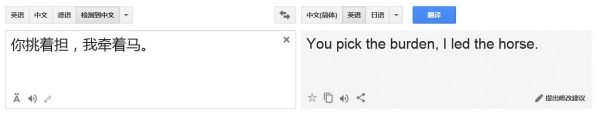

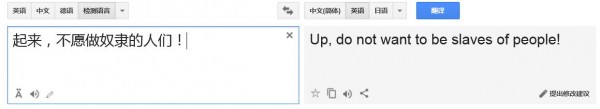

继AlphaGo战胜韩国职业棋手李世石没多久,人工智能再下一城。9月27日,谷歌推出了新的翻译系统,声称该套翻译系统基于对于人类神经思考的模仿,能够与真人翻译竞相匹敌。 在谷歌的发文《规模生产中的神经网络机器翻译》(A Neural Network for Machine Translation, at Production Scale)中,宣布将机器学习技术纳入网页和手机App翻译中,从前汉译英的尴尬局面将大为扭转。 翻译系统面世后,根据用户们的测试,发现汉译英的准确率高得惊人。 众所周知,将汉语恰切地译为英语是一件不易之事,而简单的机械翻译对于那些谷歌翻译的依赖者来说已远远不够。谷歌公司称,相较之前的算法,谷歌神经机器翻译能减少80%的错误,与通过标准测试的真人翻译所差无几。 在之前的一项西班牙语译为英语的测试中,设定满分为6分,谷歌旧的翻译系统得到3.6分,人类普遍得分为5.1分,而谷歌的新系统得到了5分的好成绩。 从前的译介模式是短语式的,翻译系统将一句话拆分成单词或者词组进行翻译,往往得到一些语句不通的结果。而新的翻译系统称之为谷歌神经机器翻译(GNMT),这项新的技术运用更少的机器设计选择,它将一句话视为整体进行解码,虽然仍是将一句话分割成若干独立单元,但每个单元都放在句子的前后进行考量。这就像一个初中生进入高中大门,为完成作业,要尝试在一本巨大的词典中查找单词和短语。神经机器翻译与以往的翻译模式用的是同样一本大词典,但旧的翻译模式只是逐个查词,而神经机器翻译却训练出两种神经网络,可以生产出另一种语言的完整的文本。这对于汉语翻译是极为重要的,因为汉语中由于搭配不同导致一个词往往有不同的意思。 翻译准确性 何以达成质的飞跃 谷歌神经网络翻译为何能够在准确性上有质的飞跃? 据悉,谷歌神经翻译克服了之前神经机器翻译在准确性和速度上的缺陷,带有8个编码层和8个解码层的长短时记忆(LSTM)网络用来增强注意以及记录瞬间感觉残留。注意力机制则连接下层解码层和上层编码层,以此来提高并行度从而降低耗时,推理计算中的低精度的算法则提升了最终的翻译速度。 第一步,网络将中文单词编码为一系列向量,每个向量代表整句话所有单词的含义。一旦整个句子被神经网络阅览,解码即开始,生成相应的英语句子。而解码则是一个将已编码的中文向量与相关的英语单词生成的加权分布的过程。连接编码解码的曲线代表解码过程中所考量到的编码词汇。

而为提高对生僻词的处理,谷歌将词语分成有限的子词单元,从而方便输入与输出。而束搜索技术则使搜索长度规格化以及具有覆盖性,这使得翻译输出的句型可大量覆盖译介语种的所有单词。这一切都可归为人工智能,人工智能算法不依赖于人类逻辑,比起人们从前使用的手工编写的算法来说,人工智能算法能找到更好的方式完成任务。人工智能网络自身会学习怎样翻译,它专注于结果如何,而不受人类思维优先的干扰。麦克·舒斯特,开发此项目的谷歌工程师说,“你不必选择,系统会全面进行翻译。” 中译英只是谷歌翻译所支持的一万种语言中的一种。谷歌表示,今后翻译将更多依赖于人工智能。在之后的几个月时间里,谷歌还会设计出适用于更多语言的谷歌神经机器翻译。当然,此种神经机器翻译还不能称得上完美,固然基于神经的人工智能表现不错,但仍有很多细微之处机器算法不能够真正领悟。比起人类翻译,谷歌神经网络翻译仍会犯许多人类翻译不会出现的错误,如掉词、误译专有名词、罕见术语,以及忽略上下文语境孤立翻译某句话等等。不过,起码这种新的翻译模式只是让意思流失在翻译结果上,而非在翻译过程中就面目全非。 |

|

|

21#

发布于:2016-10-01 04:56

|

|

|

22#

发布于:2016-10-01 09:16

你这个是神经网络翻译?链接在哪儿我看看。不是的、像http://translate.google.cn这种就不要拿上来了

前面说得很清楚,是在谈谷歌神经网络翻译的中译英准确率,根本还没上线,与此无关的免谈 |

|

|

23#

发布于:2016-10-01 09:43

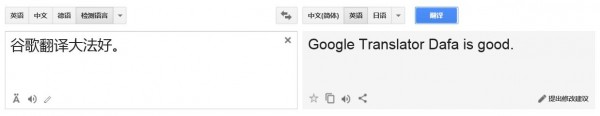

ask:你这个是神经网络翻译?链接在哪儿我看看。不是的、像http://translate.google.cn这种就不要拿上来了似乎已经上线了 据 http://www.guancha.cn/Science/2016_09_30_375963.shtml 此外,该项目开发团队还宣布GNMT汉英英汉试用版上线。现在,谷歌翻译汉英语言的移动版和网页版都率先使用GNMT,每天负责1800万次翻译任务。 据 http://weibo.com/ttarticle/p/show?id=2309351000564025441605317969 这是 GNMT 第一次正式上线,这也是第一次在传统的自然语言领域这么大规模使用新的深度学习技术,且这一次最先涉足中英领域。 现在在谷歌翻译网页上用例句进行测试 也是和报道中的截图结果是一样的 此行将启动中加总理年度对话机制,与加拿大总理杜鲁多举行两国总理首次年度对话。 |

|

|

24#

发布于:2016-10-01 22:50

嗯,不过有两个问题:

1) 我还是没在网页版上明确看到GNMT字样明示,表明当前上线版本就是GNMT版 2) 你自己输的那些例句,多数是非常成语化、文学化的单音节词居多的歌词,这个确实很难为谷歌,你要知道当前的人工智能还没有先进到能明确分辨很多转义功能过强的单音节汉语词在不同场合下语义差别的程度: i) 像“挑”,挑选的挑(由“拣”之近义引申为表“筛选”)与挑挑(挑担)的挑(表“承受”),含义无疑是不同的,谷歌并没有聪明到能把“挑担”这一动词的未完成体现在时(或:现在进行时)在前后两个音节中间的位置插入体助词“着”的“挑着担”的形式当作“挑担”的一个变位而不是将“挑着担”的“挑”单独拎出来理解为“拣”的意思的程度。 ii) 类似地,在日常生活用语中,“起来”一词通常作为状补来用(除了父母叫孩子起床时说“起来!”等场合),一般地,除了歌词等极少数场合会将“起来”前不加动词(像“站起来”to stand UP、“拾/拣起来”to pick UP这种)而单用作独立动词,谷歌还没有聪明到对你的这些歌词体文本以及一些文言文等单音节词过多的文本有极高理解力的程度 iii) 像“大法”这种词都是非常偏门的生造词,通常在词库里只会和一些约定俗成的前缀构成专有名词,例如吸星大法、乃至氵去车仑大法等等,在当前词库中如果找不到其带上述这类前缀的匹配的情况下,单独出现一个你临时生造和拼凑的新词,以当前的技术,要让processor理解,确实勉为其难了 此行将启动中加总理年度对话机制,与加拿大总理杜鲁多举行两国总理首次年度对话。 像这种新闻体文本,它的翻译准确率为什么比你那些一大堆与日常生活明显脱离的高度浓缩的单音节词占多数的歌词体、乃至诗词体的文言文形式的文本的翻译准确率高得多?看看下面我给的例子就知道了: 1) 他不想担这个责。 谷译:He did not want to take the blame. 2) 他不想承担这个责任。 谷译:He did not want to take on that responsibility. 你现在知道对于现阶段仍较初级的人工智能而言,多选长词、双音节以上歧义性小的语义明确的词让它译的重要性了吧?呵呵 当然你可能会失望:非得用这么中规中矩的标准双音节词它才能理解,那我还要这破玩意何用?白痴也知道“承担”和“责任”在此处分别是take on和responsibility啊,它在词库里一搜,搜到后进行简单代入,这不是傻瓜都会么?根本没语义分析能力分析出我单单输入一个“责”在此语境下是“责任”而不是“责怪”的意思,那它还算什么人工智能? --- 不,它其实比你想象的要聪明些。并不是只懂得简单代入操作的。 例如,你试着对比输入下面两组: 2) 他不想承担这个责任。 谷译:He did not want to take on that responsibility. 2) 他不想承担这个风险。 谷译:He did not want to take the risk. 这说明,谷歌翻译机已有能力在词块不连续(中间隔了指示代词“这个”)的条件下,“意识”到与responsibility相搭配的“承担”一词需译作take on,而与risk相搭配的“承担”一词却只需译作take就行。这个其实已经是非常了不起的高智能了。在游离语块间要能做到这种隔空感应。在技术上需要有很大的飞跃,不仅需要有基于“正则表达式”(regular expression)的模糊匹配技术的配合,而且甚至也可能已经要求机器要有“自进化学习”能力,能从一些已有的corpus中提炼出这种基于不同语境的差异化对译能力 [ask于2016-10-02 00:16编辑了帖子]

|

|

|

25#

发布于:2016-10-23 19:18

http://m.weibo.cn/single?id=4033783289702805

重大利好:【速记员要失业:微软语音识别错误率已低于人类】 微软经过训练的神经网络已可以像人工一样识别人类语音。微软让NIST 2000系统与专业速记员进行了比赛。结果显示,自动化系统的错误率首次低于人工。今年早些时候,百度研究院宣布,百度Deep Speech 2的语音速记速度比人工打字快3倍。 原文出处: http://finance.sina.cn/usstock/mggd/2016-10-23/detail-ifxwztrt0195413.d.html?wm=3049_0015 微软语音识别错率已低于人类 2016-10-23 16:40 新浪财经 ... 在周一发布的报告中,微软让NIST 2000自动化系统与专业速记员进行了比赛。结果显示,自动化系统的错误率首次低于人工。报告称:“这是会话语音领域首次报告的(自动化系统)达到人工水平。” ... ------ 这其实意味着,今后随着人工智能语音识别技术的推进,你再也不用愁找不到某些稀有语言的免费在线听力文本了,因为你将拥有一套由微软等高科技巨头自主研发的transcriptors,将所有不带文本的在线小语种(特别是稀有语言像爱沙尼亚语维洛方言võro kiilʼ视频新闻或者伊纳里萨米语anarâškielâ视频新闻这种)新闻音视频直接转录为文字,用于相关语言的听力练习,而无须再费劲去找那些带转录脚本的网站来训练稀有语言的听力和口语 [ask于2016-10-23 19:56编辑了帖子]

|

|

|

26#

发布于:2016-11-23 15:58

YLE Uutiset上居然也有带文字的北萨音频新闻,意外:

http://yle.fi/uutiset/osasto/sapmi/da_illuda_nuortalasvalggaid_vuoiti_tanja_sanila/7511924 Dá illuda nuortalašválggaid vuoiti Tanja Sanila! http://areena.yle.fi/1-3783931 Dearvva!(北萨米语) Tiõrv!(斯科特萨米语) Tiervâ!(伊纳里萨米语) http://yle.fi/radio/ylesapmi/suora YLE Sámi Radio http://www.samediggi.fi/nuorat/index.php?option=com_content&view=article&id=1%3Atervetuloa&lang=sms |

|

|

27#

发布于:2016-11-24 16:26

我的观点:

(1)只有把某个人或某群人(不管是不是翻译)的大脑里存储全部人生经历和知识下载到你的机器里面,才有可能实现与这个人或这群人同样同样质量的翻译。 (2)下载出来的知识,可以进一步加工整理,形成独立于任何天然个人的翻译能力。 (3)第(1)点是可能做到的。 (4)现阶段,新闻是受资本控制的,某种话题在新闻里忽然热起来,往往有某个领域的股票背后推手搞鬼。 |

|

|

28#

发布于:2016-12-04 16:16

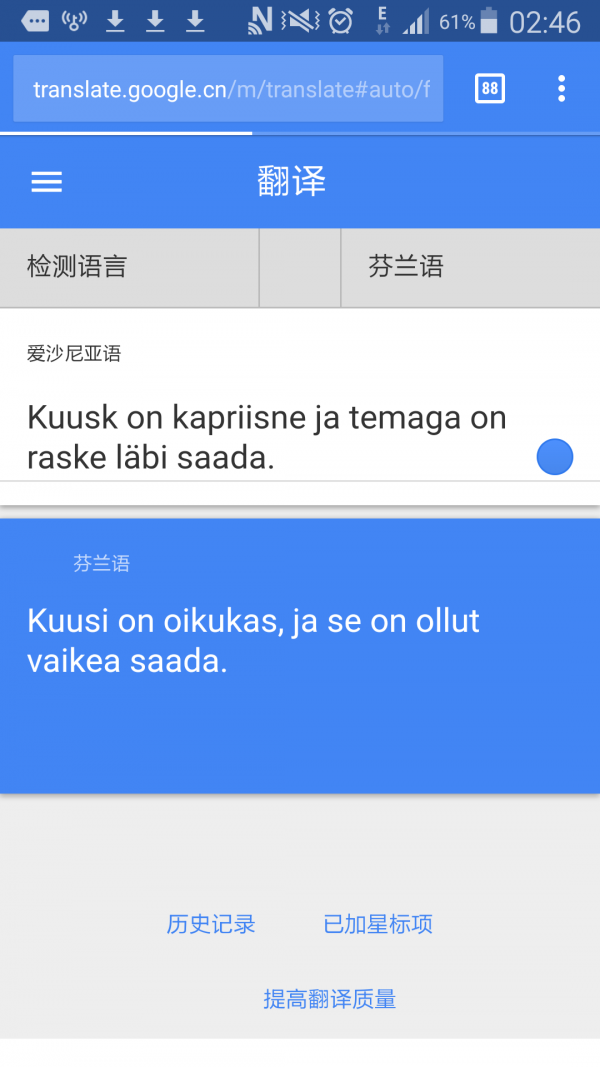

看了这个,真是忍不住了:能把kellegagi läbi saada(=tulla toimeen jonkun kanssa)“译”成这样,也算是“高”,实在是“高”得无语

你不知道läbi saada和tulla toimeen不能按字面来译,“译”成saada läpi jonkun kanssa也就算了,直接给你个saada就完事了,这叫哪门子的翻译?人工智能还有很长的路要走 [ask于2016-12-04 16:36编辑了帖子]

|

|

|

30#

发布于:2024-11-13 22:20

本来想说点啥,但是一抬头发现居然是16年的贴,楼主还在吗,人工智能翻译确实非常厉害了,而现在距离楼主所说的10年,至过了8年,应该是8年,现在是24年,甚至一些文本游戏都可以用软件直接整体翻译,但我觉得,翻译,特别是同声传译和著作的翻译还需要人,工具只能做辅助,尤其是对于后者。同声传译ai现在还不能做到,不过,如果从事翻译这个行业的话,确实不容乐观,只能寄托于小语种了

|

|

|

31#

发布于:2024-11-13 22:24

然后是语音识别,AI完胜,我的电脑上现在就跑着一个完全离线的本地化语音识别软件,准确率几乎百分之百,而这只是一个个人开发者开发的软件,大公司的技术水平可想而知,软件名叫CapsWriter-Offline-Windows-64bit,是我在github上下载的,需要的话我可以附上GitHub链接

|

|

|

32#

发布于:2024-11-17 20:36

|

|

|

33#

发布于:2024-11-18 09:28

604692228:给个GitHub link,我最近研究声纹识别智能化回到原帖https://github.com/HaujetZhao/CapsWriter-Offline |

|

|

34#

发布于:2024-11-18 09:34

604692228:给个GitHub link,我最近研究声纹识别智能化回到原帖声纹识别的话,应该要ai语音克隆吧,GPT-SoVITS 这是我所知道最强的语音克隆开源项目,希望对你有帮助 https://github.com/RVC-Boss/GPT-SoVITS |

|

|

35#

发布于:2024-11-19 15:54

|

|